Nutanix Enterprise AI มอบประสบการณ์การใช้งาน Generative AI ที่ใช้งานง่าย และครบวงจร ทั้งการใช้กับระบบที่ติดตั้งภายในองค์กร ที่ edge และ ล่าสุดบนพับลิคคลาวด์

นูทานิคซ์ (Nutanix) (NASDAQ: NTNX) ผู้นำด้านไฮบริดมัลติคลาวด์คอมพิวติ้ง ประกาศขยายแพลตฟอร์มโครงสร้างพื้นฐาน AI ของบริษัทฯ ด้วยผลิตภัณฑ์ใหม่ด้านคลาวด์เนทีฟที่เรียกว่า Nutanix Enterprise AI (NAI) โดยสามารถนำไปใช้ได้กับแพลตฟอร์ม Kubernetes ใดก็ได้บนทุกสภาพแวดล้อม ไม่ว่าจะเป็นที่ edge ในดาต้าเซ็นเตอร์หลัก หรือบนบริการพับลิคคลาวด์ ต่าง ๆ เช่น AWS EKS, Azure AKS, และ Google GKE

NAI มอบโมเดลการทำงานแบบไฮบริดมัลติคลาวด์ที่สอดคล้องกับการเร่งการประมวลผล AI ช่วยให้องค์กรสามารถใช้ประโยชน์จากโมเดล และข้อมูลขององค์กรบนโลเคชันที่ปลอดภัยได้ตามที่ต้องการ ในขณะเดียวกันก็ช่วยเพิ่มผลตอบแทนจากการลงทุน (ROI) นอกจากนี้ Nutanix Enterprise AI ใช้ NVIDIA NIM เพื่อปรับประสิทธิภาพให้เหมาะสมกับโมเดลพื้นฐานต่าง ๆ จึงสามารถช่วยให้องค์กรสามารถติดตั้งและขยายจุดปลายทาง (inference endpoints) สำหรับโมเดลภาษาขนาดใหญ่ (LLMs) เพื่อให้สามารถใช้แอปพลิเคชัน generative AI (GenAI) ได้ในหลักวินาที ไม่ใช่หลายวันหรือหลายสัปดาห์อีกต่อไป

Generative AI เป็นเวิร์กโหลดไฮบริดโดยเนื้อแท้ โดยการพัฒนาแอปพลิเคชันใหม่ ๆ มักเริ่มต้นบนระบบพับลิคคลาวด์ การปรับแต่งโมเดลด้วยข้อมูลส่วนตัวจะทำในองค์กร และการประมวลผลจะเกิดขึ้นใกล้กับการทำธุรกิจ ซึ่งอาจเป็นที่ edge ในองค์กร หรือบนระบบพับลิคคลาวด์ วิธีการแบบไฮบริดที่กระจายนี้อาจสร้างความท้าทายให้กับองค์กรในเรื่องความซับซ้อน ความเป็นส่วนตัวของข้อมูล ความปลอดภัย และค่าใช้จ่าย

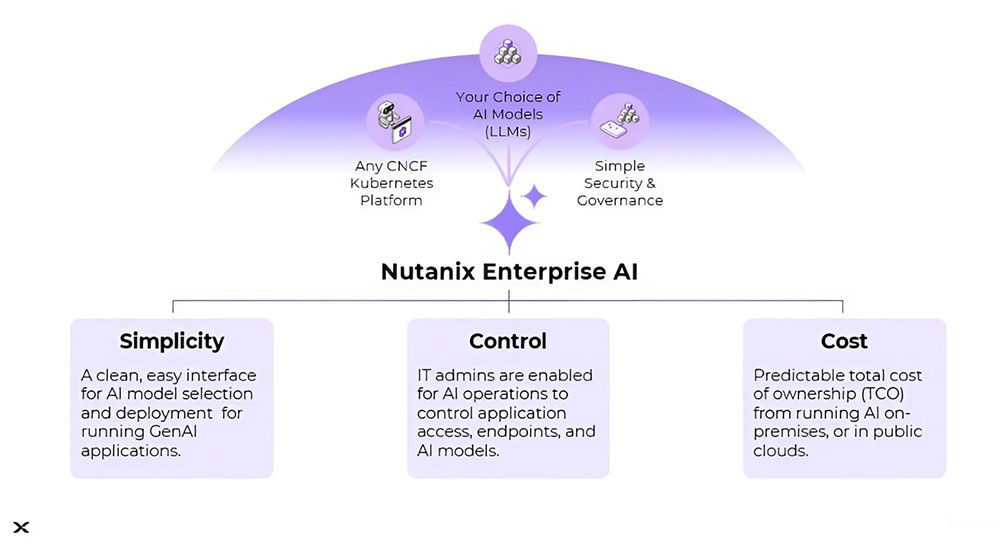

Nutanix Enterprise AI มอบรูปแบบการทำงานแบบมัลติคลาวด์ที่สอดคล้องกัน และมอบวิธีง่าย ๆ ให้สามารถใช้งาน สเกล และรัน LLMs ได้อย่างปลอดภัย ด้วย NVIDIA NIM ซึ่งเป็นไมโครเซอร์วิสด้านการอนุมานที่มีประสิทธิภาพ รวมถึงโมเดลพื้นฐานแบบเปิดต่าง ๆ จาก Hugging Face ซึ่งช่วยให้ลูกค้าสามารถใช้โครงสร้างพื้นฐาน GenAI ระดับองค์กรได้ด้วยความยืดหยุ่น สามารถดำเนินงานด้านต่าง ๆ หลังจากนำแอปพลิเคชันไปใช้แล้ว (day 2 operations) และมีความปลอดภัยในการใช้แอปพลิเคชันสำคัญทางธุรกิจตามที่องค์กรต้องการ ทั้งแอปพลิเคชันที่รันอยู่ในระบบที่ติดตั้งในองค์กร หรือบน AWS Elastic Kubernetes Service (EKS), Azure Managed Kubernetes Service (AKS), และ Google Kubernetes Engine (GKE)

นอกจากนี้ Nutanix Enterprise AI ยังนำเสนอรูปแบบการคิดราคาที่โปร่งใสและคาดการณ์ได้ โดยอิงตามทรัพยากรโครงสร้างพื้นฐานต่าง ๆ ซึ่งเป็นสิ่งสำคัญสำหรับลูกค้าที่ต้องการเพิ่ม ROI จากการลงทุนด้าน GenAI ให้ได้สูงสุด ซึ่งตรงข้ามกับการคิดราคาจากการใช้งานที่คาดการณ์ได้ยากหรือการกำหนดราคาตามโทเค็น

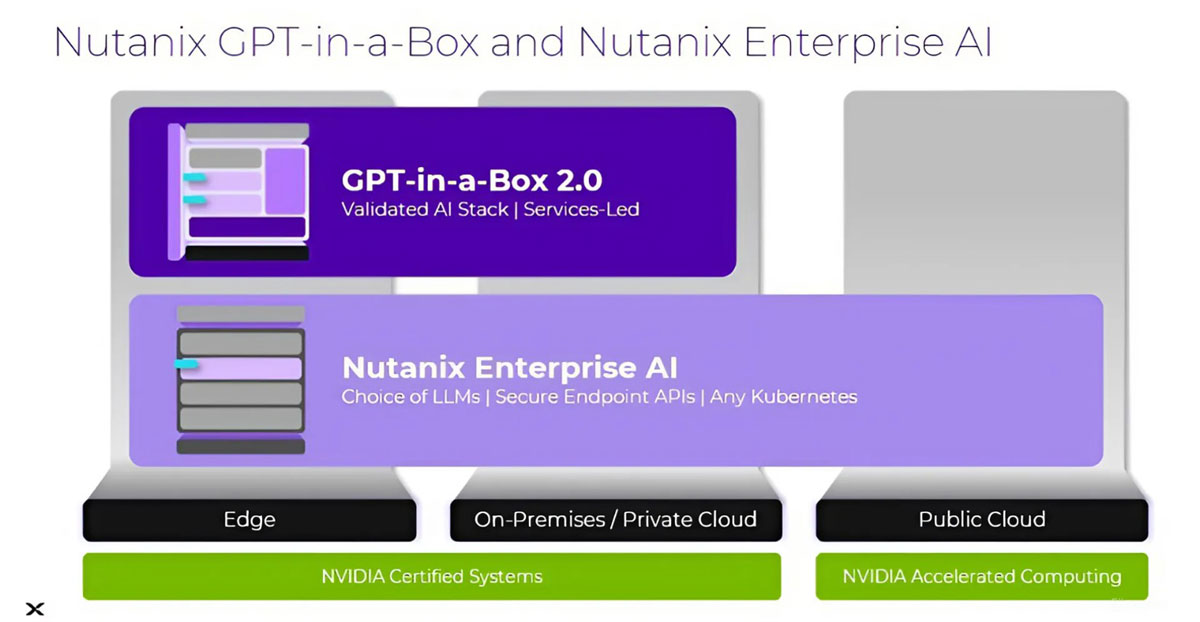

Nutanix Enterprise AI เป็นส่วนหนึ่งของ Nutanix GPT-in-a-Box 2.0 ซึ่ง GPT-in-a-Box นั้นประกอบด้วย Nutanix Cloud Infrastructure, Nutanix Kubernetes Platform, และ Nutanix Unified Storage และมาพร้อมบริการด้านต่าง ๆ ที่ช่วยให้ลูกค้าสามารถกำหนดค่าและขนาดสำหรับการฝึกอบรมและการอนุมาน AI ในองค์กรได้ตามต้องการ

นายโทมัส คอร์เนลลี่ รองประธานอาวุโสฝ่ายการจัดการผลิตภัณฑ์ของนูทานิคซ์ กล่าวว่า “Nutanix Enterprise AI ช่วยลูกค้ารันแอปพลิเคชัน GenAI ได้อย่างง่ายดายและปลอดภัย ทั้งในระบบภายในองค์กรหรือบนพับลิคคลาวด์ Nutanix Enterprise AI สามารถรองรับแพลตฟอร์ม Kubernetes ใด ๆ ก็ได้ และช่วยให้แอปพลิเคชัน AI รันอยู่บนโลเคชันที่ปลอดภัย ด้วยรูปแบบค่าใช้จ่ายที่คาดการณ์ได้”

Nutanix Enterprise AI สามารถนำไปใช้กับแพลตฟอร์ม AI แบบฟลูสแต็กของ NVIDIA ได้ และผ่านการตรวจสอบการใช้งานกับแพลตฟอร์มซอฟต์แวร์ NVIDIA AI Enterprise ซึ่งรวมถึง NVIDIA NIM ซึ่งเป็นชุดไมโครเซอร์วิสที่ใช้งานง่ายและได้รับการออกแบบมาเพื่อรองรับการปรับใช้และอนุมานโมเดล AI ประสิทธิภาพสูงได้อย่างปลอดภัยและเชื่อถือได้

นายจัสติน โบอิตาโน รองประธานฝ่าย Enterprise AI ของ NVIDIA กล่าวว่า “เวิร์กโหลด Generative AI เป็นไฮบริดโดยธรรมชาติอยู่แล้ว ด้วยการเทรน การปรับแต่ง และการอนุมาน ที่ทำได้ทั้งบนพับลิคคลาวด์ต่าง ๆ ในระบบภายในองค์กร และที่ edge การผสานรวม NVIDIA NIM เข้ากับ Nutanix Enterprise AI เป็นการมอบโมเดลมัลติคลาวด์ที่สอดคล้องกันและ APIs ที่ปลอดภัยให้ลูกค้า ช่วยให้ลูกค้าใช้ AI บนสภาพแวดล้อมที่ต่างกันได้ด้วยประสิทธิภาพและความปลอดภัยสูง ตามที่แอปพลิเคชันสำคัญทางธุรกิจจำเป็นต้องใช้”

Nutanix Enterprise AI ช่วยลูกค้าดังนี้

- จัดการกับปัญหาการขาดแคลนบุคลากรที่มีทักษะด้าน AI: ความเรียบง่าย ทางเลือกที่มีให้ และฟีเจอร์ต่าง ๆ ที่ติดตั้งมาเรียบร้อย ช่วยให้ผู้ดูแลระบบไอทีสามารถเป็นผู้ดูแลด้าน AI ได้ ช่วยเร่งการพัฒนา AI โดยนักวิทยาศาสตร์ข้อมูลและนักพัฒนาซอฟต์แวร์ ด้วยการใช้โมเดลล่าสุดต่าง ๆ และการเร่งการประมวลผลบนกราฟิกการ์ด NVIDIA

- ลดอุปสรรคด้านการสร้างแพลตฟอร์มที่พร้อมใช้กับ AI: องค์กรจำนวนมากที่ต้องการใช้ GenAI มักประสบปัญหาในการสร้างแพลตฟอร์มที่เหมาะสมสำหรับรองรับเวิร์กโหลด AI โดยเฉพาะการรักษาความสอดคล้องระหว่างโครงสร้างพื้นฐานในองค์กรและพับลิคคลาวด์หลายแห่ง Nutanix Enterprise AI จัดการปัญหานี้ด้วยเวิร์กโฟลว์แบบ UI-driven ที่ใช้งานง่าย ช่วยให้ลูกค้าปรับใช้และทดสอบ LLM inference endpoints ได้ในเวลาไม่กี่นาที นอกจากนี้ยังรองรับไมโครเซอร์วิส NVIDIA NIM ที่สามารถรันที่ใดก็ได้ ช่วยให้มั่นใจได้ว่าโมเดลจะได้รับการปรับประสิทธิภาพให้เหมาะสมกับการใช้งานทั้งบนสภาพแวดล้อมคลาวด์และในระบบที่ติดตั้งอยู่ภายในองค์กร ทั้งยังรองรับ Hugging Face และโมเดลมาตรฐานต่าง ๆ นอกจากนี้ การบูรณาการอย่างเป็นเนื้อเดียวกันกับ Nutanix Kubernetes Platform ยังช่วยให้สามารถใช้คุณประโยชน์ที่มีอยู่ใน Nutanix Cloud Platform ทั้งหมด หรือมอบทางเลือกให้ลูกค้าสามารถรันบนรันไทม์ของ Kubernetes ใด ๆ ก็ได้

ซึ่งรวมถึง AWS EKS, Azure AKS, หรือ Google Cloud GKE ด้วยการเร่งการประมวลผลบนกราฟิกการ์ด NVIDIA

- บรรเทาความกังวลเรื่องความเป็นส่วนตัวและความปลอดภัยของข้อมูล Nutanix Enterprise AI ช่วยลดความเสี่ยงด้านความเป็นส่วนตัวและความปลอดภัย โดยการช่วยให้ลูกค้ารันโมเดลและข้อมูลต่าง ๆ บนทรัพยากรประมวลผลที่ควบคุมได้ด้วยตนเอง นอกจากนี้ Nutanix Enterprise AI ยังมีแดชบอร์ดที่ใช้งานง่าย เพื่อใช้แก้ปัญหา ตรวจสอบ และใช้ทรัพยากรที่ใช้สำหรับ LLMs รวมถึงสามารถควบคุมการเข้าใช้งานตามบทบาท (RBAC) ได้อย่างปลอดภัยและรวดเร็ว เพื่อให้มั่นใจว่าสามารถควบคุมและเข้าใจการเข้าใช้ LLM ได้ องค์กรที่ต้องการความปลอดภัยที่แน่นหนา ทั้งยังสามารถนำไปใช้ในสภาพแวดล้อมที่มีการตัดการเชื่อมต่อกับเครือข่ายที่ไม่ปลอดภัย (air-gapped) หรือไซต์แบบสแตนด์อโลนที่เตรียมไว้แต่ไม่เผยแพร่ (dark-site) ได้

- นำโครงสร้างพื้นฐานไอทีระดับองค์กรไปใช้กับเวิร์กโหลด GenAI ลูกค้าที่กำลังใช้ Nutanix Cloud Platform กับแอปพลิเคชันสำคัญทางธุรกิจ สามารถนำความยืดหยุ่น, Day 2 operations, และความปลอดภัยไปใช้กับเวิร์กโหลด GenAI ไปใช้กับโครงสร้างพื้นฐานขององค์กรได้

ตัวอย่างการใช้ประโยชน์จาก Nutanix Enterprise AI

- เพิ่มประสบการณ์ลูกค้าด้วย GenAI ที่ทำการวิเคราะห์ความคิดเห็นตอบกลับจากลูกค้าและเอกสารต่าง ๆ

- เร่งความเร็วในการสร้างโค้ดและคอนเทนต์ด้วยการใช้ co-pilots และการประมวลผลเอกสารอัจฉริยะ

- ใช้ประโยชน์จากโมเดลที่ได้รับการปรับแต่งอย่างละเอียดต่าง ๆ บน domain-specific data เพื่อเร่งการสร้างโค้ดและคอนเทนต์

- สร้างความปลอดภัยที่รัดกุมมากขึ้น ซึ่งรวมถึงการใช้ประโยชน์จากโมเดล AI ต่าง ๆ ในการตรวจจับการฉ้อโกง ตรวจจับภัยคุกคาม การแจ้งเตือนที่สมบูรณ์ และการสร้างนโยบายอัตโนมัติ

- เพิ่มประสิทธิภาพด้านการวิเคราะห์ต่าง ๆ ผ่านการใช้โมเดลเกี่ยวกับข้อมูลส่วนตัวต่าง ๆ ที่ได้รับการปรับแต่งอย่างละเอียด

Nutanix Enterprise AI ที่สามารถรันได้ทั้งในระบบภายในองค์กร ที่ edge หรือบนพับลิคคลาวด์และ Nutanix GPT-in-a-Box 2.0 พร้อมให้บริการแก่ลูกค้าแล้ว สำหรับข้อมูลเพิ่มเติม สามารถเยี่ยมชมเว็บไซต์ของเราได้ที่ Nutanix.com/enterprise-ai

คำกล่าวสนับสนุน

- นายเจฟฟ์ บูดิเยร์ หัวหน้าฝ่ายผลิตภัณฑ์ของ Hugging Face กล่าวว่า “ความร่วมมืออย่างแนบแน่นระหว่างทีม Nutanix และ Hugging Face ช่วยให้ลูกค้าของ Nutanix Enterprise AI สามารถใช้งานโอเพ่นโมเดลยอดนิยมได้อย่างราบรื่นในสแต็กที่ใช้งานง่ายและผ่านการทดสอบอย่างเต็มรูปแบบ ซึ่งขณะนี้ใช้ได้บนพับลิคคลาวด์แล้วด้วย”

- นายเดฟ เพียร์สัน รองประธานฝ่ายวิจัยโครงสร้างพื้นฐานของ IDC กล่าวว่า “Nutanix Enterprise AI มุ่งมั่นมอบแพลตฟอร์มโครงสร้างพื้นฐานที่ใช้งานง่าย ด้วยการมอบประสบการณ์การใช้งานที่สอดคล้องกันจากองค์กรไปสู่พับลิคคลาวด์เพื่อสนับสนุนองค์กรต่าง ๆ ในทุกย่างก้าวของการใช้ AI ตั้งแต่การใช้บนพับลิคคลาวด์ไปจนถึงที่ edge”